Интеграция с Kilo Code

Узнайте, как интегрировать LLMost с Kilo Code для доступа к сотням AI моделей через единый API

Обзор

LLMost является OpenAI-совместимой платформой, что позволяет легко интегрировать её с Kilo Code. LLMost предоставляет доступ к широкому спектру языковых моделей от различных провайдеров через единый API.

Настройка

1. Получение API ключа

Для начала работы вам необходимо получить API ключ от LLMost:

- Перейдите на llmost.ru

- Зарегистрируйтесь и войдите в свой аккаунт

- Перейдите в раздел Ключи API

- Скопируйте ваш сгенерированный API ключ

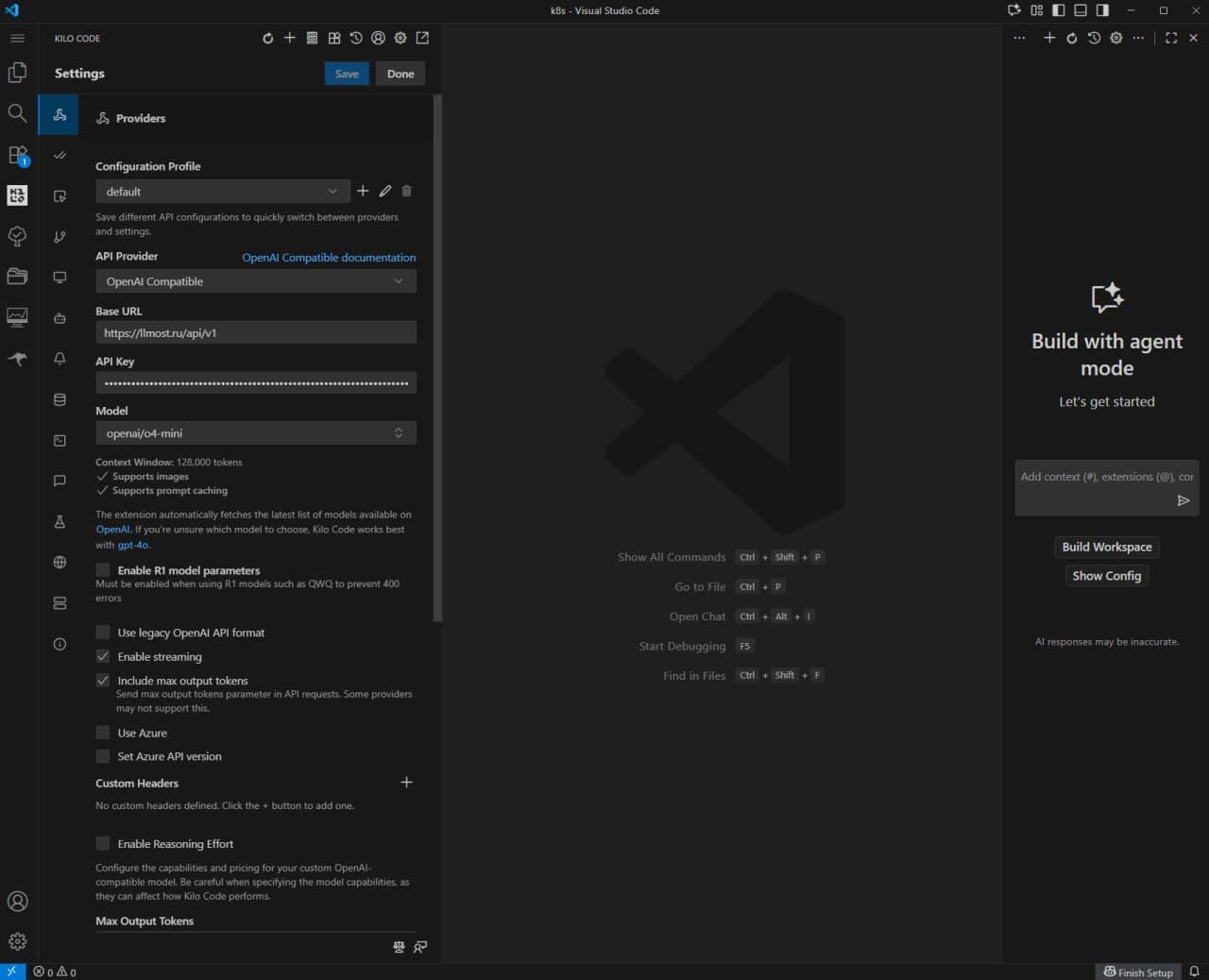

2. Конфигурация в Kilo Code

После получения API ключа выполните следующие шаги:

- Откройте настройки Kilo Code

- Выберите OpenAI Compatible в качестве провайдера

- Введите ваш API ключ от LLMost

- Выберите модель из доступного выпадающего списка

Настройка базового URL: При конфигурации провайдера LLMost в Kilo Code, установите базовый URL:

https://llmost.ru/api/v1Детальная настройка параметров

После базовой конфигурации вы увидите панель настроек со следующими параметрами:

На скриншоте выше показан пример настроенного провайдера LLMost в Kilo Code с моделью openai/o4-mini.

Основные параметры

- API Provider: Выберите "OpenAI Compatible"

- Base URL:

https://llmost.ru/api/v1 - API Key: Вставьте ваш API ключ от LLMost

- Model: Выберите модель из списка (например,

openai/o4-mini)

Информация о модели

После выбора модели вы увидите:

- Context Window: Размер контекстного окна (например, 128,000 токенов)

- Supports images: Поддержка обработки изображений

- Supports prompt caching: Поддержка кэширования промптов

Дополнительные опции

В настройках доступны следующие параметры:

- Enable R1 model parameters: Включить специальные параметры для R1 моделей

- Use legacy OpenAI API format: Использовать устаревший формат API (обычно не требуется)

- Enable streaming: Включить потоковую передачу ответов (рекомендуется)

- Include max output tokens: Отправлять параметр max_output_tokens в API запросах

- Enable Reasoning Effort: Настроить уровень детализации рассуждений модели

Дополнительные настройки

- Custom Headers: Добавьте пользовательские HTTP заголовки при необходимости

- Max Output Tokens: Максимальное количество токенов в ответе

Ключевые возможности

Доступ к моделям

LLMost автоматически предоставляет доступ к своему полному, актуальному каталогу моделей через интерфейс Kilo Code. Вы можете выбрать из сотен доступных моделей, включая:

- GPT-5 и GPT-4o от OpenAI

- Claude от Anthropic

- Gemini от Google

- Llama от Meta

- И многие другие модели от различных провайдеров

Оптимизация сообщений

Платформа предлагает опциональную функцию трансформации сообщений "middle-out" для сжатия промптов, превышающих ограничения контекста модели. Это особенно полезно при работе с длинными разговорами или большими объемами контекста.

Управление маршрутизацией

Вы можете настроить маршрутизацию запросов между провайдерами через:

- Приоритеты сортировки: цена, пропускная способность, задержка

- Политики данных: ограничения на обучение, уровни хранения данных

Дополнительные возможности

Кэширование промптов

Некоторые провайдеры поддерживают кэширование промптов, что позволяет значительно снизить затраты и время ответа для повторяющихся запросов. Доступность этой функции зависит от конкретной модели.

Подробнее о кэшировании промптов читайте в документации по кэшированию промптов.

Ценообразование

Ценообразование следует тарифам базовых моделей. Актуальную информацию о ценах можно найти на странице моделей LLMost.

Устранение неполадок

Проблемы с подключением

Если вы испытываете проблемы с подключением:

- Проверьте правильность API ключа

- Убедитесь, что базовый URL установлен корректно:

https://llmost.ru/api/v1 - Проверьте доступность выбранной модели

Ошибки аутентификации

Если возникают ошибки аутентификации:

- Убедитесь, что API ключ активен

- Проверьте баланс вашего аккаунта

- Убедитесь, что у ключа есть необходимые разрешения

Поддержка

Если у вас возникли вопросы или проблемы с интеграцией:

- Проверьте документацию LLMost

- Изучите справочник API

- Напишите на support@llmost.ru

Следующие шаги

- Изучите доступные модели

- Прочитайте о кэшировании промптов

- Ознакомьтесь со справочником API